Author:baiyucraft

BLog: baiyucraft’s Home

原文:《动手学深度学习》

前文:深度学习 6.线性回归概述 - baiyucraft’s Home

1 2 import randomimport torch

1.生成数据集 我们首先根据带有噪声的线性模型构造一个人造的数据集,我们的任务是使用这个有限样本的数据集来恢复这个模型的参数。 我们将使用低维数据,这样可以很容易地将其可视化。

我们使用预设的权重 w = [ 2 , − 3.4 ] T w = [2,-3.4]^{\mathrm{T}} w = [ 2 , − 3.4 ] T b = 4.2 b = 4.2 b = 4.2 ϵ \epsilon ϵ X \boldsymbol{X} X y \boldsymbol{y} y

y = X w + b + ϵ \boldsymbol{y} = \boldsymbol{Xw} + b + \epsilon y = Xw + b + ϵ

你可以将 ϵ \epsilon ϵ ϵ \epsilon ϵ ϵ \epsilon ϵ

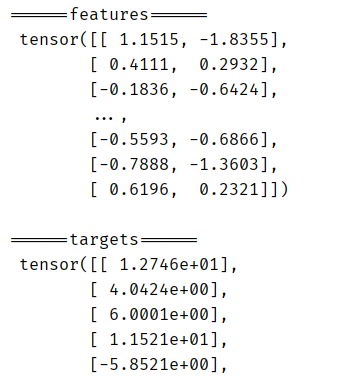

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 def synthetic_data (w, b, num_examples ):"""合成数据,生成 y = Xw + b + 噪声。""" 0 , 1 , (num_examples, len (w)))0 , 0.01 , y.shape)return X, y.reshape(-1 , 1 )2 , -3.4 ])4.2 1000 )print ('\n======features======\n' , features)print ('\n======targets======\n' , targets)

运行结果:

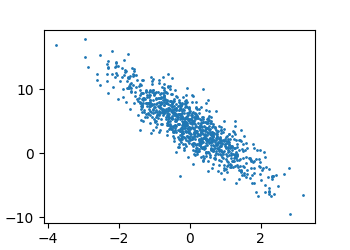

通过生成第二个特征 features[:, 1] 和 targets 的散点图,可以直观地观察到两者之间的线性关系:

1 2 3 4 5 1 ].numpy(), targets.numpy(), s=1 )

运行结果:

2.读取数据集 这里定义一个data_iter 函数,该函数能打乱数据集中的样本并以小批量方式获取数据,这样就能使用小批量随机梯度下降:

1 2 3 4 5 6 7 8 9 10 11 12 13 def data_iter (batch_size, features, targets ):"""接收批量大小、特征矩阵和标签向量作为输入,生成大小为batch_size的小批量""" len (features)list (range (num_examples))for i in range (0 , num_examples, batch_size):yield features[batch_indices], targets[batch_indices]

3.定义模型 线性回归模型是 y = X w + b \boldsymbol{y} = \boldsymbol{Xw} + b y = Xw + b b b b

1 2 3 4 def linreg (X, w, b ):"""线性回归模型。""" return torch.matmul(X, w) + b

4.定义损失函数 因为要更新模型。需要计算损失函数的梯度,这里采用的是平方损失函数:

1 2 3 def squared_loss (y_hat, y ):"""均方损失(平方误差)""" return (y_hat - y.reshape(y_hat.shape)) ** 2 / 2

5.定义优化算法 小批量随机梯度下降的工作示例:

在每一步中,使用从数据集中随机抽取的一个小批量,然后根据参数计算损失的梯度。接下来,朝着减少损失的方向更新我们的参数。 下面的函数实现小批量随机梯度下降更新。该函数接受模型参数集合¥ p a r a m s params p a r am s w \boldsymbol w w b b b l r lr l r b a t c h _ s i z e batch\_size ba t c h _ s i ze l r lr l r b a t c h _ s i z e batch\_size ba t c h _ s i ze

p a r a m ← p a r a m t − 1 − l r b a t c h _ s i z e ∑ i ∈ b a t c h _ s i z e ∂ ∂ p a r a m t − 1 l ( i ) ( [ p a r a m s ] ) \boldsymbol{param} \gets \boldsymbol{param_{t-1}} - \dfrac{lr}{batch\_size} \sum_{i \in batch\_size}\dfrac{\partial}{\partial \boldsymbol{param_{t-1}}} l^{(i)}([params]) param ← para m t − 1 − ba t c h _ s i ze l r i ∈ ba t c h _ s i ze ∑ ∂ para m t − 1 ∂ l ( i ) ([ p a r am s ])

1 2 3 4 5 6 7 8 9 def sgd (params, lr, batch_size ):"""小批量随机梯度下降。params(优化参数,例w、b),lr(学习率)""" with torch.no_grad():for param in params:

6.训练 做好了前文中的定义,我们就可以开始训练了。训练过程是:

在每次迭代中,我们读取一小批量训练样本,并通过我们的模型来获得一组预测。 计算完损失后,我们开始反向传播,存储每个参数的梯度。最后,我们调用优化算法 sgd 来更新模型参数。

具体执行是:

初始化参数 w 和 b 重复,直到完成计算梯度 g ← ∂ ∂ ( w , b ) l ( x ( i ) , y ( i ) , w , b ) g \gets \dfrac{\partial}{\partial (\boldsymbol{w},b)} l\left(\boldsymbol{x}^{(i)}, y^{(i)}, \boldsymbol{w},b\right) g ← ∂ ( w , b ) ∂ l ( x ( i ) , y ( i ) , w , b ) 更新参数 ( w , b ) ← ( w , b ) − l r b a t c h _ s i z e g (\boldsymbol{w},b) \gets (\boldsymbol{w},b) - \dfrac{lr}{batch\_size} g ( w , b ) ← ( w , b ) − ba t c h _ s i ze l r g 在每个迭代周期epoch中,我们使用 data_iter 函数遍历整个数据集,并将训练数据集中所有样本都使用一次(假设样本数能够被批量大小整除)。这里的迭代周期个数num_epochs和学习率lr都是超参数,分别设为3和0.03。(设置超参数很棘手,需要通过反复试验进行调整。之后会讲解)。

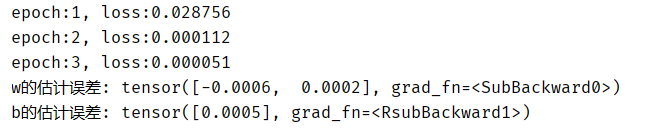

因为我们使用的是自己合成的数据集,所以我们知道真正的参数是什么。 因此,我们可以通过比较真实参数和通过训练学到的参数来评估训练的成功程度。事实上,真实参数和通过训练学到的参数确实非常接近。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 0 , 0.01 , size=(2 , 1 ), requires_grad=True )1 , requires_grad=True )10 0.03 3 for epoch in range (num_epochs):for X, y in data_iter(batch_size, features, targets):sum ().backward()with torch.no_grad():print (f'epoch:{epoch + 1 } , loss:{float (train_l.mean()):f} ' )print (f'w的估计误差: {true_w - w.reshape(true_w.shape)} ' )print (f'b的估计误差: {true_b - b} ' )

运行结果:

注意,我们不应该想当然地认为我们能够完美地恢复参数。 在机器学习中,我们通常不太关心恢复真正的参数,而更关心那些能高度准确预测的参数。 幸运的是,即使是在复杂的优化问题上,随机梯度下降通常也能找到非常好的解。其中一个原因是,在深度网络中存在许多参数组合能够实现高度精确的预测。